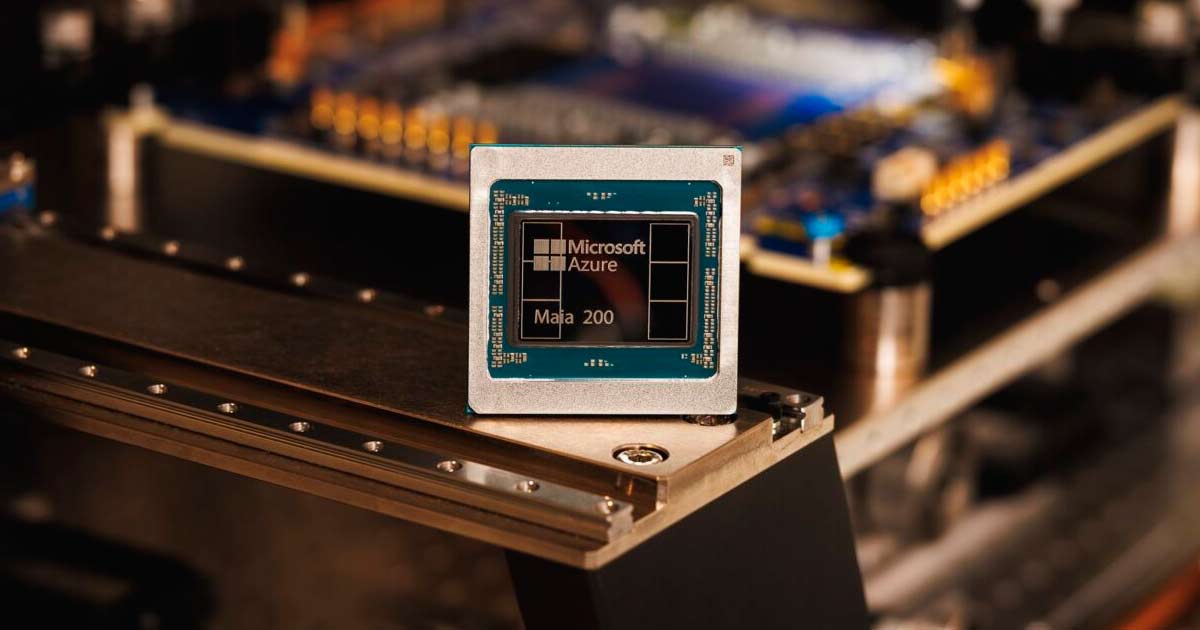

Microsoft presenta Maia 200, su nuevo acelerador de IA para potenciar la inferencia en Azure

27 de Enero de 2026Diseñado para optimizar la inferencia de modelos a gran escala en Azure, mejorar el rendimiento por dólar y reforzar la base tecnológica que impulsa servicios como Microsoft 365 Copilot y los modelos de IA del futuro

Microsoft anunció el lanzamiento de Maia 200, su acelerador de inteligencia artificial de próxima generación, desarrollado para hacer más rápida, eficiente y rentable la ejecución de modelos de IA a gran escala en la nube. El nuevo chip refuerza la infraestructura que sostiene servicios clave como Azure y Microsoft 365 Copilot, y marca un nuevo avance en la estrategia de silicio propio de la compañía.

Diseñado específicamente para optimizar la inferenciación de modelos de inteligencia artificial —es decir, la etapa en la que los modelos ya entrenados generan respuestas—, Maia 200 apunta a resolver uno de los grandes desafíos actuales de la IA generativa: escalar el rendimiento sin disparar los costos ni el consumo energético. Según Microsoft, se trata del sistema de inferencia más eficiente que la empresa ha desplegado hasta el momento, con un 30 % más de rendimiento por dólar frente al hardware más avanzado de su flota actual.

Un chip pensado para la nueva era de la IA generativa

Fabricado con el proceso de 3 nanómetros de TSMC, Maia 200 integra más de 140 mil millones de transistores y fue optimizado para trabajar con modelos que utilizan computación de baja precisión, una tendencia clave en la evolución de los grandes modelos de lenguaje. Cada acelerador ofrece más de 10 petaFLOPS en FP4 y más de 5 petaFLOPS en FP8, lo que le permite ejecutar sin inconvenientes los modelos más exigentes del mercado actual y prepararse para los de próxima generación.

Más allá de la potencia de cálculo, Microsoft puso el foco en otro factor crítico: el movimiento de datos. Maia 200 incorpora un sistema de memoria rediseñado que incluye 216 GB de HBM3e, 272 MB de SRAM integrada y un ancho de banda de hasta 7 TB/s. Esta combinación permite una generación de tokens más rápida y eficiente, reduciendo latencias y mejorando la experiencia final de los usuarios.

Optimizado para Azure, Copilot y los modelos del futuro

Maia 200 forma parte de la infraestructura heterogénea de IA de Microsoft y será utilizado para ejecutar múltiples modelos avanzados, incluidos los más recientes GPT-5.2 de OpenAI. Su despliegue impactará directamente en servicios como Microsoft Foundry y Microsoft 365 Copilot, mejorando tanto el desempeño como la eficiencia operativa de estas plataformas.

Además, el acelerador será una pieza clave para el equipo de Microsoft Superintelligence, que lo utilizará en tareas estratégicas como generación de datos sintéticos y aprendizaje por refuerzo, fundamentales para el desarrollo de modelos internos de próxima generación.

Escalabilidad y eficiencia a nivel de centro de datos

A nivel de sistemas, Maia 200 introduce una arquitectura de red de dos niveles basada en Ethernet estándar, lo que permite escalar clústeres de hasta 6.144 aceleradores con alta eficiencia, confiabilidad y menores costos energéticos. Dentro de cada bandeja, cuatro aceleradores están completamente interconectados, optimizando el rendimiento en cargas de inferencia intensiva.

Este diseño unificado simplifica la programación, mejora la flexibilidad de las cargas de trabajo y reduce costos operativos, manteniendo un desempeño consistente en los centros de datos de Azure a escala global.

Desarrollo nativo en la nube y despliegue acelerado

Microsoft destacó que Maia 200 fue desarrollado bajo un enfoque nativo en la nube, validando el sistema completo —desde el chip hasta el centro de datos— incluso antes de la disponibilidad final del silicio. Gracias a este modelo de co-desarrollo, los primeros modelos de IA comenzaron a ejecutarse en Maia 200 apenas días después de la llegada del primer chip.

Actualmente, el nuevo acelerador ya está desplegado en la región US Central de Azure, con planes de expansión hacia US West 3 y otras regiones del mundo en el corto y mediano plazo.

Con Maia 200, Microsoft refuerza su apuesta por una infraestructura de IA propia, eficiente y escalable, convencida de que el hardware especializado será un factor decisivo en la próxima etapa de la inteligencia artificial a gran escala y en la evolución de los servicios cloud que impulsan el negocio digital global.